Como usar o Robots.Txt para bloquear subdomínios

Um site é uma boa maneira de promover sua pequena empresa, bem como mostrar seus produtos e qualificações exclusivas. Se você gerencia um site grande, provavelmente usa alguns subdomínios e cada subdomínio tem sua própria pasta no seu host. Se você não quiser que os indexadores de mecanismos de pesquisa analisem e indexem determinados subdomínios, use o arquivo robots.txt para bloqueá-los.

1

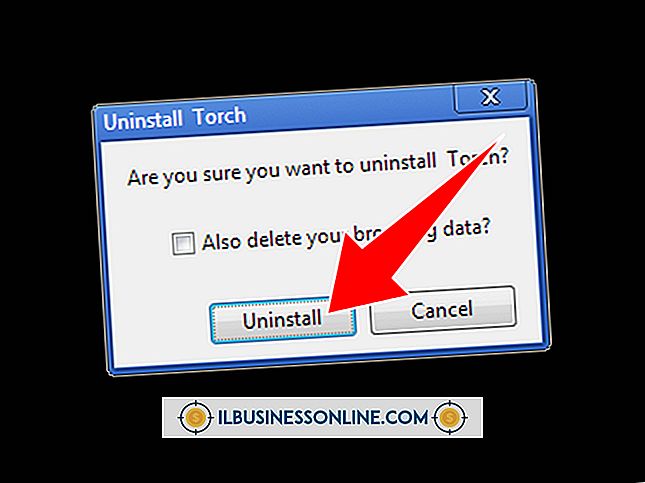

Clique no botão Iniciar no canto inferior esquerdo da tela.

2

Digite "Notepad" na caixa de busca na parte inferior do menu Iniciar.

3

Clique em "Bloco de notas" na seção Programas, na parte superior do menu Iniciar, para iniciar o Bloco de notas. Um novo documento é criado automaticamente no bloco de notas.

4

Insira essas duas linhas no documento do Bloco de Notas para impedir que todos os robôs analisem o subdomínio:

User-agent: * Não permitir: /

5

Pressione "Ctrl-S" para abrir a janela "Salvar como".

6

Digite "robots.txt" na caixa "Nome do arquivo", selecione uma pasta onde você deseja salvar o arquivo e clique em "Salvar" para salvá-lo.

7

Faça o upload do arquivo robots.txt que você salvou no diretório raiz de cada domínio que você deseja proteger dos rastreadores do mecanismo de pesquisa. O diretório raiz é o diretório de nível superior.

Gorjeta

- Você pode fazer o upload do arquivo usando qualquer software cliente de FTP ou até mesmo o gerenciador de arquivos da Web do seu host.